양 손으로 물건을 잡는 순간 인공지능이 이를 실시간 수준으로 인식해 정확한 3D 위치를 파악하는 기술이 개발됐다.

인공지능대학원 백승렬 교수팀은 두 손과 물체의 3차원 포즈(자세)를 실시간으로 예측하는 인공지능 모델 ‘QORT-Former’를 개발했다.

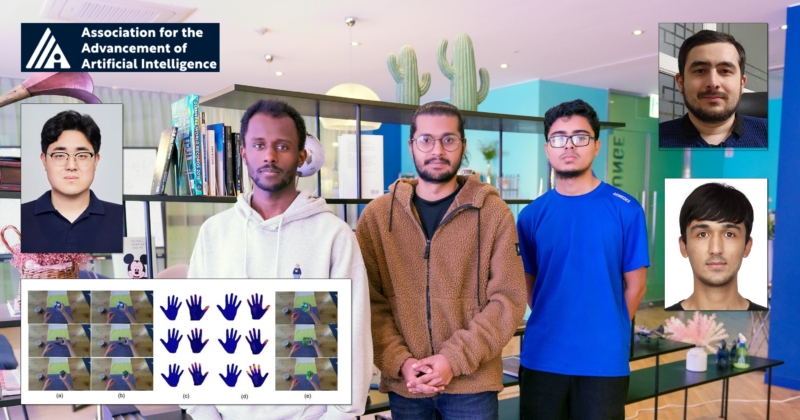

사람은 손의 움직임을 눈으로 바로 이해할 수 있지만, 컴퓨터는 그렇지 않다. 눈 대신 카메라로 얻은 2D 이미지만 가지고, 손과 물체가 실제 공간에서 어디에 있고, 어떤 모양으로 잡혀 있는지 3D 위치를 추정해야만 한다.

‘QORT-Former’는 이 위치 추정의 속도를 기존보다 2배 이상 향상시킨 인공지능 모델로, 이 모델을 적용하면 VR이나 AR 영상에서 딜레이가 없는 자연스러운 상호작용이 가능하다.

연구팀은 기존 딥러닝 모델인 트랜스포머의 쿼리(query)처리 방식을 변경해 이 같은 인공지능 모델을 개발했다. 트랜스포머의 경우, 300개의 무작위 쿼리를 사용하기 때문에 실시간 수준의 위치 추정이 불가능 했다. 쿼리는 AI가 화면 속 어떤 정보를 집중해서 봐야하는 지를 선택하는 데 중요한 역할을 하는 AI 구성요소다.

개발된 모델은 왼손, 오른손, 물체로 쿼리를 구분해 처리한다. 또 접촉 위치 정보를 반영해 정확도가 높다. 기존 최고 수준의 모델 대비 H2O 데이터셋 기준으로 왼손 17.6%, 오른손 22.8%, 물체 27.2% 더 높은 정확도를 보였으며, 처리 속도는 초당 53.5프레임을 기록했다.

백승렬 교수 “QORT-Former는 사람의 손이 물체를 어떻게 다루고 있는지를 영상 한 장만으로 빠르고 정확하게 이해할 수 있는 AI”라며, “실시간성과 정확도를 동시에 확보한 이번 성과는 AR·VR 기반 인터랙션 기술의 핵심 전환점이 될 것” 이라고 기대했다.

이번 연구는 엘칸 이스마일자다(Elkhan Ismayilzada) 연구원, 세이엠 카레쿠자만(MD Khalequzzaman Chowdhury Sayem) 연구원이 제1저자로 참여했으며, 연구결과는 세계적인 인공지능학회인 AAAI 2025에 채택됐다.

연구 수행은 정보통신기획평가원, 과학기술정보통신부 한국연구재단, CJ AI 센터 등의 지원을 받아 이뤄졌다.